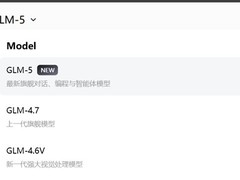

2026年2月12日,智谱正式推出新一代大语言模型GLM-5。摩尔线程随即在旗舰级AI训推一体全功能GPU——MTT S5000上,依托SGLang推理框架,于模型发布当日即完成全流程适配与验证。

这一高效响应并非偶然。从GLM-4.6、GLM-4.7到此次GLM-5,摩尔线程已将“发布即适配”确立为标准实践。凭借自研MUSA架构全面的算子支持与优异的生态兼容性,团队顺利贯通GLM-5推理全链路,并充分激活MTT S5000原生FP8加速能力。该方案在保障模型精度的同时,大幅缩减显存占用,显著提升推理效率。

面对GLM-5对长序列处理的高要求,MTT S5000展现出突出优势:依托充沛的算力储备与高计算密度,叠加硬件层面对于稀疏Attention机制的原生支持,模型在处理超长上下文任务时仍能维持高吞吐率与低延迟表现。

支撑这一快速适配能力的核心,是MUSA软件栈的敏捷性。其中,TileLang原生算子单元测试覆盖率已突破80%,使多数通用算子可直接复用,有效降低移植门槛,同时确保团队能持续、快速地响应前沿模型架构与新特性的迭代演进。

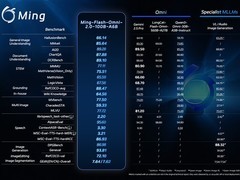

GLM-5定位为当前最具实力的编程专用大模型,整体性能相较前代提升达20%。其核心突破在于Agentic Engineering(代理工程)能力——不仅具备扎实的代码生成与理解基础,更能胜任复杂系统工程设计与长周期Agent任务,实现从需求分析、架构设计到应用部署的端到端自主开发。

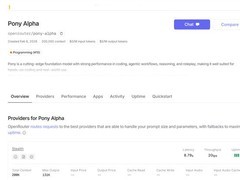

在国际权威评估机构Artificial Analysis发布的最新榜单中,GLM-5位列全球第四、开源模型首位。其编程能力已与Claude Opus 4.5齐平,在主流开源基准测试中刷新SOTA纪录:在SWE-bench-Verified和Terminal Bench 2.0两项测试中,分别取得77.8分与56.2分,均为当前开源模型最高分,超越Gemini 3 Pro。在内部构建的Claude Code评估体系中,GLM-5于前端开发、后端实现、长程任务等关键编程场景下,全面超越GLM-4.7,平均提升幅度超过20%;可仅需极少人工介入,独立完成Agentic长周期规划与执行、后端服务重构及深度调试等系统级工程任务,实际使用体验已高度接近Opus 4.5水平。

评论

更多评论