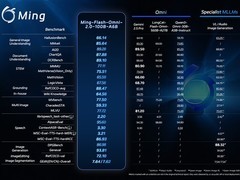

2026年2月11日,蚂蚁集团正式开源全模态大模型 Ming-Flash-Omni 2.0。

该模型在多项公开基准测试中表现优异,涵盖视觉语言理解、语音可控生成、图像生成与编辑等核心能力,部分指标已超过 Gemini 2.5 Pro,树立了当前开源全模态大模型性能的新高度。

Ming-Flash-Omni 2.0 是业内首个支持全场景音频统一生成的大模型,可在单条音轨中同步生成人声、环境音效与背景音乐。用户仅需使用自然语言下达指令,即可对音色、语速、语调、音量、情绪表达及方言特征等维度实现精细化调控。模型在推理阶段达到3.1Hz的极低帧率,支持分钟级长度音频的实时高保真合成,在推理效率与资源消耗控制方面处于行业前列。

蚂蚁集团长期深耕全模态技术领域,Ming-Omni 系列历经三轮迭代演进。本次开源 Ming-Flash-Omni 2.0,标志着其底层核心能力以可复用、可集成的技术底座形式全面开放,为端到端多模态应用的研发提供统一的能力支撑入口。

该模型基于 Ling-2.0 架构构建,采用混合专家(MoE)结构,参数规模达百亿级,其中活跃参数约60亿。整体设计围绕“看得更准、听得更细、生成更稳”三大目标展开系统性优化:

在视觉能力上,融合亿级细粒度标注数据与难例增强训练策略,显著提升对近缘动植物种类、精密工艺细节及稀有文物等高难度对象的识别精度;

在音频能力上,实现语音、音效、音乐的同轨协同生成,支持自然语言驱动的多维参数调节,并具备零样本音色克隆与个性化定制能力;

在图像能力上,强化复杂编辑任务的稳定性与一致性,支持光影重映射、场景替换、人物姿态调整及一键式智能修图等功能,即使在动态连续画面中亦能保持视觉连贯性与细节真实性。

目前,Ming-Flash-Omni 2.0 的模型权重与推理代码已在主流开源社区上线,用户可通过 Hugging Face 等平台获取。同时,也可登录蚂蚁百灵官方平台 Ling Studio,在线体验模型功能并进行实际调用。

评论

更多评论