2026年2月9日,小米MiMo大模型团队正式发布HySparse混合稀疏注意力架构。该架构专为Agent时代设计,采用“极少量全注意力加稀疏注意力”的协同结构,在保障关键信息捕获能力的同时显著提升计算与存储效率,为超长文本处理提供兼顾精度与成本的新范式,也为大模型注意力机制的优化路径带来系统性参考。

当前,Agent类模型及应用正经历快速演进,对模型处理超长上下文的能力提出更高要求。这一能力已不再仅关乎技术可行性,更直接关联实际部署的经济性与实时性。Agent需在万字乃至更长的上下文中稳定完成信息检索、逻辑推理与多步任务规划,同时确保响应速度满足交互需求。行业面临的核心瓶颈,正从“能否完成计算”,转向“是否负担得起计算”。

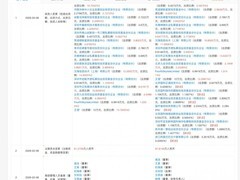

HySparse正是针对这一现实挑战提出的架构级解决方案。在涵盖通用能力、数学推理、代码生成及中文理解等多维度评测中,该架构在7B稠密模型与80B混合专家模型两种典型规模下均展现出持续稳定的性能增益。以80B-A3BMoE模型为例,在总计49层中仅保留5层全注意力,模型整体能力未下降,反而在部分任务上有所提升;KV缓存占用降低近十倍,实现性能与资源效率的双重优化。RULER长文本基准测试进一步验证:即便大幅削减全注意力层数,HySparse仍能可靠维持对远距离关键信息的访问能力,凸显其混合结构的鲁棒性与适应性。

HySparse标志着大模型注意力设计从单纯追求算力可及性,向兼顾计算效益与部署可行性的关键跃迁。作为MiMo系列注意力技术的延续,它在MiMo-V2-Flash所采用的混合滑动窗口注意力(Hybrid SWA)基础上实现重要演进——通过引入全局性、高价值token的信息补充机制,使稀疏结构与全注意力形成兼容互补关系。该改进在提升建模能力的同时,未增加KV缓存开销,亦未带来明显额外计算负担。

团队表示,后续将持续推进HySparse在更大参数规模模型上的验证工作,深入探索全注意力层数的压缩极限,进一步释放超长上下文处理的效能潜力。相关成果也将面向学术界与工业界开放,旨在为混合稀疏注意力方向的研究与实践提供可借鉴的技术路径与实践经验。

评论

更多评论