随着代理式人工智能应用的迅速普及,人工智能系统对内存架构的需求正经历一次深层次的结构性调整。

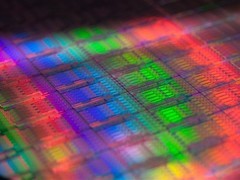

业内多家技术企业正在为下一代人工智能产品及机架级计算平台评估采用SOCAMM内存模块方案。该标准最初由部分厂商主导制定,旨在满足高性能AI芯片对灵活内存配置的需求。与传统直接焊接于主板的低功耗双倍数据率内存不同,SOCAMM采用模块化封装形式,支持热插拔与后期升级,在容量扩展性、能效控制与系统适应性之间实现了更优的协同平衡。

在代理式AI运行模式下,模型需持续维护长周期上下文、运行状态及多任务记忆,这对短期高容量内存提出了前所未有的需求。单纯依赖高带宽内存虽可满足带宽要求,但在单位容量成本、整机功耗和可扩展性方面面临明显瓶颈。因此,一种兼顾容量、功耗与部署灵活性的中间层内存架构逐渐成为行业共识,SOCAMM由此进入主流视野。

据业内人士介绍,借助SOCAMM方案,单颗处理器或加速器平台可实现TB级内存配置,足以支撑人工智能代理同时维持数百万token的活跃上下文状态。尽管其峰值带宽与数据吞吐能力不及高带宽内存,但在每瓦特性能、系统级扩展效率以及部署弹性方面展现出独特优势,被视为与高带宽内存协同工作的理想补充层级。

在具体实现路径上,部分厂商正探索有别于既有方案的设计思路。例如,有企业拟采用方形结构的DRAM模块,并将电源管理芯片直接集成于模块本体,实现电源调节功能前移,提升供电精度与系统稳定性。

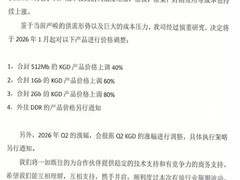

从产业化节奏看,已有厂商明确将新一代SOCAMM 2纳入其高端AI计算平台的产品路线图,并计划随量产规模扩大逐步提升其在整机内存配置中的比重。与此同时,相关DRAM供应商已收到明确的年度采购规划指引,其中主要产能由一家韩国头部厂商承担,另一家韩国厂商位居第二梯队,第三位供应商则来自美国。

评论

更多评论