1月2日,Signal65发布了最新的SemiAnalysis InferenceMAX基准测试分析报告。在Deepseek-R1 0528混合专家(MoE)模型的推理性能评估中,英伟达Blackwell架构的GB200 NVL72机架系统展现出显著优势,大幅领先于AMD的Instinct MI355X解决方案。

混合专家模型作为当前主流的AI架构之一,以Deepseek-R1 0528为代表,在执行任务时并非调用全部参数,而是根据输入内容动态激活最相关的子模块,即“专家”单元,从而提升计算效率。然而,该架构在扩展至大规模集群时,会面临节点间频繁数据交换所带来的通信延迟与带宽压力,成为制约性能的关键瓶颈。

为应对这一挑战,英伟达采用“极致协同设计”策略,通过将72颗芯片在单个机架内实现高度集成,并配置高达30TB的高速共享内存,显著优化了全对全通信模式下的数据传输效率,有效缓解了分布式推理中的延迟问题。

测试结果显示,在相近的集群配置条件下,英伟达GB200 NVL72方案在每GPU吞吐量上达到75 tokens/秒,性能约为AMD Instinct MI355X的28倍。对于大型云服务提供商而言,总体拥有成本是决策的重要依据。结合公开的云平台定价数据进行分析,GB200 NVL72不仅在性能上占据绝对优势,单位token处理成本也仅为竞品方案的十五分之一,同时支持更高的交互响应速度。

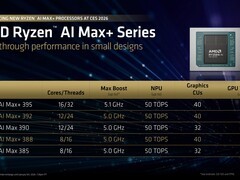

尽管英伟达在MoE模型推理领域目前处于领先地位,但AMD的产品仍具备特定场景下的竞争力。其MI355X凭借大容量HBM3e内存,在处理密集型模型(Dense Models)时依然表现出较强的性能潜力。不过,报告指出,AMD尚未推出可对标NVL72级别的新一代机架级系统。展望未来,随着AMD Helios平台与英伟达Vera Rubin平台的逐步落地,双方在高端AI基础设施层面的竞争将更加深入和激烈。

评论

更多评论