今年2月,NVIDIA推出了Chatwith RTX,作为一个本地部署的聊天机器人,它用到了TensorRT-LLM 和NVIDIA RTX 加速技术,是显卡应用大语言模型的一个技术演示demo。

最近,NVIDIA宣布——Chatwith RTX正式更名为ChatRTX。这次的更新增加了许多新功能,例如在新版本中加入了对智谱AI的ChatGLM3-6B这个中文LLM的支持,同时还支持语音交互和图像搜索功能。

语音识别功能的加入,意味着用户可以通过语音对话的形式与ChatRTX进行交互,极大提升了使用的便捷性。集成了Whisper(AI语音识别系统)后,用户可使用语音搜索数据,该系统使用AI处理口语并提供支持多种语言的文本响应。只需单击麦克风图标并与ChatRTX交谈即可开始使用,ChatRTX将提供文本响应。

图像方面,全新ChatRTX支持OpenAI的CLIP模型,它可根据你给出的信息搜索本地指定目录里面的图片,在大量本地图片中找出符合指令要求的图片。这项功能意味着其可识别和理解图片内容,无需复杂的元数据标记,用户只需用文字描述图片,ChatRTX就能“看懂”图片并进行检索、排序等操作。

与ChatGPT等在线AI聊天类工具不同,NVIDIAChatRTX不需要云端计算,这对用户的隐私和数据保密性更好。ChatRTX还支持扫描和分析本地文件目录的能力,支持指定格式的文件,用户可使用该功能搭建本地的数据资料库,只需要给出文件夹路径,AI就会在数秒内把它们加载到库中。

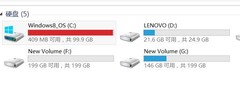

除了功能性有所增强,体积优化整合能力也是这次更新的重点。ChatRTX全新安装包的体积大幅缩减,从此前的35GB减少到12GB,但安装完后程序仍需要约35GB的空间,因此在下载之前要留够足够的空间。

至于硬件需求,从NVIDIA的官网我们可以看到,目前ChatRTX只支持GeForceRTX 30和GeForceRTX 40系芯片组的产品,显存需求起步容量为8GB。电脑内存则需要16GB以上的容量,且需在Windows11的系统环境下运行。

总结来说,ChatRTX并没有到“功能强大”的级别,实用性和交互体验无法与在线AI聊天工具相媲美,因此目前仍旧只能作为技术演示的应用。但是它的优点也非常明显,即更快的响应速度和更好的隐私保护。

ChatRTX运行在GeForce RTX PC 的Windows 系统上,无需通过云端的运算则省去了传输的延迟,因此其速度很快。ChatRTX并不依赖云服务,且用户的数据仅保存在本地,因此可以在本地PC 上处理敏感数据,无需与第三方共享数据或连接互联网,实现更强大的隐私保护。

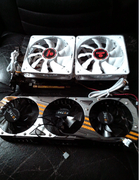

相信随着这款应用的后期更新和完善,未来NVIDIA会把一个更好用的本地大语言模型工具的“完全体”带给大家。想体验全新ChatRTX的用户,推荐使用索泰GeForceRTX 4070 SUPER X-GAMING OC 欧泊白显卡。

这款显卡搭载基于全新AdaLovelace架构的GPU核心,内置第四代Tensorcore,对于大语言模型应用等AI软件的优化更强。同时,它还搭载12GB的GDDR6X高速显存,能满足ChatRTX对于显存的需求。

除了游戏画面加速、3D应用加速等基础指标。越来越多的消费者开始关注显卡的AI运算能力,索泰GeForceRTX 4070 SUPER X-GAMING OC 欧泊白拥有568 TOPS 的AI 算力,成为现阶段性价比相当高的一款AIGC创意生产力显卡。

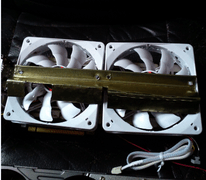

用料上,这款显卡也毫不含糊。它拥有三具大尺寸暗影疾风扇叶,能带来更高风压和更大风量,搭配卡身大面积镂空风道,可实现高效畅顺散热。纯白卡身加上涂鸦印纹的外观辨识度很高,同时这样的设计也非常讨好年轻玩家,很好地迎合了纯白DIY装机潮的需求。

评论

更多评论