近年来,人工智能技术的飞速发展,催生了各种各样的创新应用。在这之中,AI聊天机器人的发展在各个行业领域中都展现出了巨大的潜力。那最近,作为全球领先的显卡制造商NVIDIA则宣布推出一款AI聊天机器人“Chatwith RTX”。根据描述,该机器人能够与用户进行自然、流畅的对话,最重要的是只需本地的RTX显卡即可运行。

Chat withRTX借助检索增强生成(RAG)、NVIDIATensorRT-LLM软件及NVIDIARTX加速技术,将生成式AI功能引入由GeForce赋能的本地WindowsPC。相比于现在市面上主流的AI聊天,它并非是在网页和APP中运行,用户需要将其下载到个人电脑中。这样在效果上不仅运行速度会更快,在使用上也不会受太多外部因素的限制,真正意义上的本地运行。

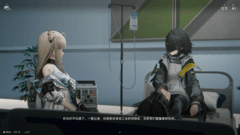

用户可快速轻松地将桌面端上的资料当成数据集,连接到Mistral或Llama2这一类开源大型语言模型,以便快速查询与上下文有关的内容。

这款AI聊天机器人不仅具备了出色的语义理解和自然语言的生成能力,还能够根据用户的需求提供个性化的服务和答复。用户可以加入YouTube视频和播放列表里的信息,在ChatwithRTX里加入视频网址,并根据视频中的内容进行你想要的提问,它便会以极快的速度进行回复。这一突破性的技术将进一步推动人机交互的革新,并有望在智能助手、在线客服、教育辅助等领域发挥重要作用。

作为人工智能领域的巨头之一,OpenAI一直以其先进的技术和研究成果著称,其开发的GPT系列模型在自然语言处理领域表现出了惊人的能力。然而如今,NVIDIA推出的最新AI聊天机器人Chatwith RTX也展现出了强大的竞争实力,尤其是其能够在本地运行的特点,为用户提供了更多的选择和便利。

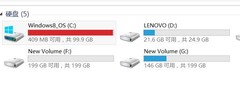

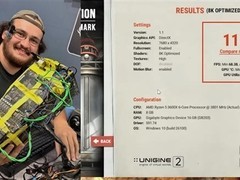

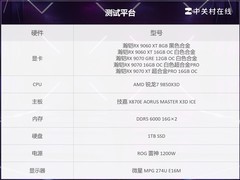

Chat WithRTX的用法很简单,只需一个下载安装的动作,就可以在自家的电脑上进行使用。当然除了要搭配30系以上的GPU之外,使用Chatwith RTX还需要搭配操作系统Windows10或11以及最新的NVIDIAGPU驱动。在大小上也需要用户空出约至少35G以上的空间大小,各位在安装上还请不要忘记检查下自己的硬盘空间是否充足。此外安装的过程对于网络也有严格的限制,想要体验的朋友可以看看自己是否满足以上条件。

如果说之前人们不使用Chatgpt等AI对话的技术,是担心泄露私人隐私于云端服务器。那ChatwithRTX是基于深度学习技术和大规模数据训练而成的,借助于强大的RTX显卡,在本地环境下即可运行,无需依赖于云端服务器。你唯一需要的或许就只是配备好GeForceRTX 30系列或更高版本的GPU(至少8GB显存)即可。

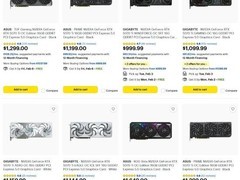

全新影驰GeForceRTX 40 SUPER系列GPU包括GeForceRTX 4070 SUPER、4070Ti SUPER 和4080 SUPER,在AI工作负载方面,GeForceRTX 4080 SUPER生成视频的速度比RTX3080 Ti快1.5倍,生成图像的速度比RTX3080 Ti快1.7倍。作为在PC上体验AI最佳的显卡系列,专用AITensor Core可提供高达836AI TOPS,在游戏、创作和日常工作等方面提供革命性的AI性能。

Chat WithRTX的横空出世引发了业界的热议,也展现出了人工智能技术在日常生活中的巨大潜力。随着技术的不断创新和应用,相信AI聊天机器人将成为未来智能化生活的重要组成部分,为用户带来更加便捷、智能的体验。

评论

更多评论