OpenAI的聊天机器人ChatGPT在全球范围内广受欢迎,然而,最新的研究显示,该机器人在关键领域——癌症治疗方案的生成上,存在严重错误,远不能取代人类专家。这项研究由美国哈佛医学院附属的布里格姆妇女医院的研究人员进行,结果发表在《美国医学会肿瘤学杂志》上。 研究人员向ChatGPT提出了各种癌症病例的治疗方案,结果发现三分之一的回答中包含了不正确的信息。研究还指出,ChatGPT倾向于将正确和错误的信息混合在一起,因此很难识别哪些信息是准确的。该研究的合著者Danielle Bitterman博士表示,他们对错误信息与正确信息混合在一起的程度感到震惊,这使得即使是专家也很难发现错误。 ChatGPT于2022年11月推出后迅速走红,两个月后就达到了1亿活跃用户。尽管ChatGPT取得了成功,但生成型人工智能模型仍然容易出现“幻觉”,即自信地给出误导性或完全错误的信息。 人工智能融入医疗领域的努力已经在进行中,主要是为了简化管理任务。本月早些时候,一项重大研究发现,使用人工智能筛查乳腺癌是安全的,并且可能将放射科医生的工作量减少近一半。哈佛大学的一位计算机科学家最近发现,最新版本的模型GPT-4可以轻松通过美国医学执照考试,并暗示它比一些医生具有更好的临床判断力。 然而,由于ChatGPT等生成型模型存在准确性问题,它们不太可能在近期取代医生。《美国医学会肿瘤学杂志》上的研究发现,ChatGPT的回答中有12.5%是“幻觉”,并且在被问及晚期疾病的局部治疗或免疫疗法时,最有可能给出错误的信息。OpenAI已经承认ChatGPT可能不可靠,该公司的使用条款警告说,他们的模型并非旨在提供医疗信息,也不应该用于“为严重的医疗状况提供诊断或治疗服务”。

相关电商优惠

vivo S20(8GB/256GB)

¥2299

6人评分

77%好评

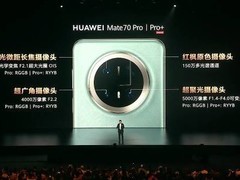

HUAWEI Mate 70(12GB/512GB)

¥5999

5人评分

76%好评

iQOO 13(12GB/256GB)

¥3999

8人评分

68%好评

ROG 游戏手机9 Pro(16GB/512GB)

¥6299

1人评分

64%好评

Redmi K70至尊版(12GB/256GB)

¥2499

610人评分

78%好评

评论

更多评论