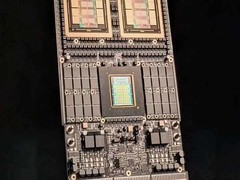

据韩国媒体最新报道,NVIDIA已决定停止第一代SOCAMM内存的开发工作,并将研发重点转移至下一代SOCAMM2。此前,SOCAMM被定位为一种模块化的LPDDR内存方案,旨在为AI服务器提供接近HBM的高带宽和低功耗表现。然而,受限于技术进展未达预期,该计划最终被重新调整。

在GB300 NVL72的规格设计中,SOCAMM1曾被赋予高容量与高带宽的期望,支持最高达18TB的LPDDR5X内存容量以及14.3TB/s的数据带宽,被视为未来数据中心计算架构的重要替代方案之一。

据消息称,SOCAMM2在性能方面将有明显提升,数据速率有望从上一代的8533MT/s提高到9600MT/s,并可能兼容未来LPDDR6标准,从而进一步增强其在AI计算领域的适用性。

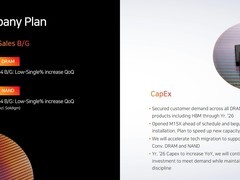

在产业链方面,美光已于今年三月宣布率先实现SOCAMM1的量产,并成为首家将该产品导入AI服务器的内存供应商。相比之下,三星与SK海力士则仅在财报电话会议中透露计划于2025年第三季度启动量产。倘若SOCAMM1项目最终被完全放弃,将为这两大厂商提供追赶美光的机会。

此前市场普遍预期,SOCAMM系列在2025年的出货量有望达到60万至80万颗,显示出NVIDIA原本对该技术的快速导入抱有高度期待。如今由SOCAMM1直接跳过过渡版本进入SOCAMM2阶段,可能反映出NVIDIA正加快技术更迭节奏,以巩固其在AI领域的竞争优势。

评论

更多评论